In un nuovo studio pubblicato su arXiv, il team di ricerca sull’intelligenza artificiale di Apple ha messo in luce importanti carenze nei modelli di linguaggio di grandi dimensioni (Large Language Models, LLM), tra cui quelli sviluppati da OpenAI e Meta, nel gestire compiti di ragionamento matematico e logico.

L’indagine dimostra come variazioni minime nella formulazione delle domande possano causare gravi discrepanze nelle risposte, sollevando dubbi sulla loro affidabilità in scenari che richiedono coerenza logica.

Il focus dello studio è la valutazione delle capacità di ragionamento logico dei modelli di linguaggio. Nonostante la potenza e la diffusione di modelli come GPT-4 di OpenAI o Llama di Meta, Apple sottolinea come questi non utilizzino una logica formale, ma si basino principalmente su un riconoscimento sofisticato di schemi appresi durante l’addestramento. Questo approccio comporta vulnerabilità che emergono chiaramente nei test.

Ad esempio, un problema matematico semplice, che chiedeva di calcolare quanti kiwi una persona aveva raccolto in più giorni, è stato distorto quando sono state aggiunte informazioni irrilevanti sulla dimensione dei kiwi. In questo caso, modelli come GPT-4 e Llama hanno erroneamente modificato il totale finale, nonostante il dato aggiunto non avesse alcun impatto sul risultato corretto.

Lo studio evidenzia un problema persistente nei modelli di linguaggio. Il loro approccio al ragionamento è fragile e basato sul riconoscimento di modelli, non sulla logica. “Non abbiamo trovato prove di ragionamento formale nei modelli di linguaggio”, affermano i ricercatori, aggiungendo che piccoli cambiamenti, come la semplice modifica dei nomi nei problemi, possono alterare significativamente le risposte, fino a un 10% di variazione.

Questa dipendenza dal pattern matching rende i modelli particolarmente suscettibili a errori quando incontrano dati che differiscono anche solo minimamente rispetto a quelli visti durante l’addestramento. Tali risultati indicano una preoccupante fragilità che limita l’efficacia dell’AI in contesti dove è richiesta una coerenza rigorosa, come il calcolo matematico o la risoluzione di problemi complessi.

I risultati dello studio sono un campanello d’allarme per lo sviluppo futuro dell’intelligenza artificiale, soprattutto in applicazioni che richiedono una logica affidabile. Secondo Apple, tutti i modelli testati, inclusi quelli open-source come Llama e quelli proprietari come GPT-4, hanno mostrato un significativo calo delle prestazioni quando esposti a variazioni insignificanti nei dati di input.

Per superare questo ostacolo, Apple suggerisce che un approccio innovativo potrebbe consistere nell’integrazione dei modelli neurali con tecniche di ragionamento simbolico tradizionale, creando un’AI “neurosimbolica”. Questo approccio combinato potrebbe migliorare la capacità di decision-making dell’AI, fornendo soluzioni più precise e affidabili.

- Filtra:

- Tutte

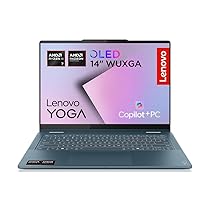

- Apple

- Minimo Storico

- Alimentari e cura della casa

- Amazon

- Auto e moto

- Bellezza

- Cancelleria e prodotti per ufficio

- Casa e cucina

- Commercio

- Elettronica

- Fai da te

- Giardino e giardinaggio

- Giochi e giocattoli

- Grandi elettrodomestici

- Illuminazione

- Informatica

- Moda

- Prima infanzia

- Prodotti per animali domestici

- Salute e cura della persona

- Sport e tempo libero

- Videogiochi

Leggi o Aggiungi Commenti