l team di ricerca Apple Intelligence ha recentemente rilasciato due nuovi modelli linguistici di piccole dimensioni ma ad alte prestazioni, utilizzati per il training di generatori AI. Questi modelli rappresentano un passo avanti significativo nell’open-source DataComp for Language Models project, a cui Apple partecipa insieme ad altri leader del settore.

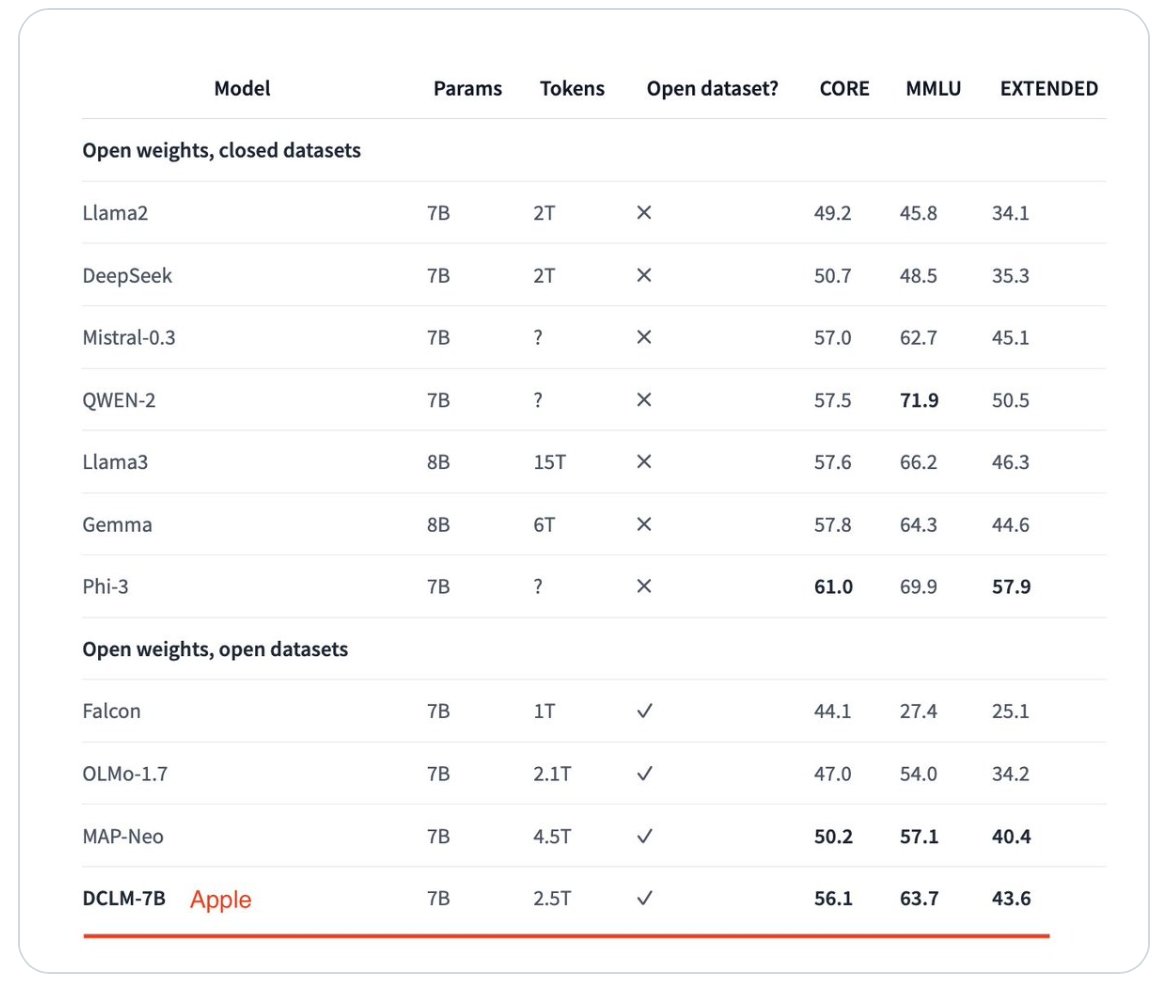

I modelli linguistici come quelli sviluppati da Apple sono fondamentali per l’addestramento di motori AI, come ChatGPT, fornendo una struttura standard che include architettura, parametri e filtraggio dei dataset per garantire dati di alta qualità. La recente proposta di Apple include due modelli: uno più grande con sette miliardi di parametri e uno più piccolo con 1,4 miliardi di parametri. Secondo il team della società, il modello più grande ha superato il precedente top model, MAP-Neo, del 6,6% nei benchmark.

Ciò che rende ancora più notevole il lavoro del team di Apple è che il modello DataComp-LM utilizza il 40% in meno di potenza di calcolo per raggiungere questi benchmark. Si è rivelato il modello più performante tra quelli con dataset aperti, risultando anche competitivo contro quelli con dataset privati.

Apple ha reso i suoi modelli completamente open source: dataset, modelli di peso e codice di training sono tutti disponibili per altri ricercatori. Sia il modello più grande che quello più piccolo hanno ottenuto punteggi elevati nei benchmark del Massive Multi-task Language Understanding (MMLU), risultando competitivi con i modelli commerciali.

Durante la conferenza WWDC di giugno, la società ha presentato Apple Intelligence e Private Cloud Compute, dimostrando di essere all’avanguardia nelle applicazioni di intelligenza artificiale nei propri dispositivi. I documenti di ricerca pubblicati dal team di Machine Learning di Apple, sia prima che dopo l’evento, hanno confermato il ruolo di leader del settore dell’azienda.

I modelli rilasciati dal team di Apple non sono destinati all’uso in prodotti futuri, ma sono progetti di ricerca comunitaria volti a mostrare l’efficacia migliorata nella cura di dataset piccoli o grandi utilizzati per l’addestramento di modelli AI. Il team di Machine Learning di Apple ha già condiviso precedentemente ricerche con la comunità AI più ampia. I dataset, le note di ricerca e altri asset sono disponibili su HuggingFace.co, una piattaforma dedicata all’espansione della comunità AI.

Leggi o Aggiungi Commenti