Apple ha annunciato nuove funzionalità di accessibilità in arrivo entro la fine dell’anno, tra cui l’Eye Tracking, un modo per gli utenti con disabilità fisiche di controllare iPad o iPhone con gli occhi.

Inoltre, Music Haptics offrirà un nuovo modo per gli utenti sordi o ipoudenti di vivere la musica utilizzando il Taptic Engine dell’iPhone; le scorciatoie vocali permetteranno agli utenti di eseguire compiti emettendo un suono personalizzato; le indicazioni sul movimento del veicolo possono aiutare a ridurre il mal d’auto durante l’uso di iPhone o iPad in un veicolo in movimento; e altre funzionalità di accessibilità arriveranno su visionOS. Queste funzionalità combinano la potenza dell’hardware e del software di Apple, sfruttando il chip, l’intelligenza artificiale e l’apprendimento automatico per continuare l’impegno decennale di Apple nel progettare prodotti per tutti.

“Abbiamo una profonda fiducia nel potere trasformativo dell’innovazione nel migliorare le vite”, ha dichiarato Tim Cook. “Ecco perché per quasi 40 anni, Apple ha sostenuto il design inclusivo inserendo l’accessibilità al centro del nostro hardware e software. Continuiamo a spingere i confini della tecnologia e queste nuove funzionalità riflettono il nostro impegno duraturo nel fornire la migliore esperienza possibile a tutti i nostri utenti.”

“Ogni anno facciamo passi da gigante in termini di accessibilità”, ha detto Sarah Herrlinger, direttore senior di Politiche e Iniziative di Accessibilità Globale di Apple. “Queste nuove funzionalità avranno un impatto sulla vita di un’ampia gamma di utenti, offrendo nuovi modi per comunicare, controllare i propri dispositivi e muoversi nel mondo.”

L’Eye Tracking arriva su iPad e iPhone

Alimentato dall’intelligenza artificiale, l’Eye Tracking offre agli utenti un’opzione integrata per navigare su iPad e iPhone solo con gli occhi. Progettato per gli utenti con disabilità fisiche, la funzionalità utilizza la fotocamera frontale per configurarsi e calibrarsi in pochi secondi e, con l’apprendimento automatico on-device, tutti i dati utilizzati per configurare e controllare questa funzione sono mantenuti in modo sicuro sul dispositivo e non vengono condivisi con Apple.

L’Eye Tracking funziona su app di iPadOS e iOS e non richiede hardware o accessori aggiuntivi. Con questa nuova funzione, gli utenti possono navigare attraverso gli elementi di un’app e utilizzare il Dwell Control per attivare ogni elemento, accedendo a funzioni aggiuntive come pulsanti fisici, swipe e altri gesti solo con gli occhi.

Music Haptics rende la musica più accessibile

Music Haptics è un nuovo modo per gli utenti sordi o ipoudenti di vivere la musica su iPhone. Con questa funzionalità di accessibilità attivata, il Taptic Engine dell’iPhone riproduce tocchi, texture e vibrazioni raffinate che si sincronizzano con la musica. Music Haptics funziona su milioni di brani nel catalogo di Apple Music e saranno disponibili come API per gli sviluppatori per rendere la musica più accessibile nelle loro app.

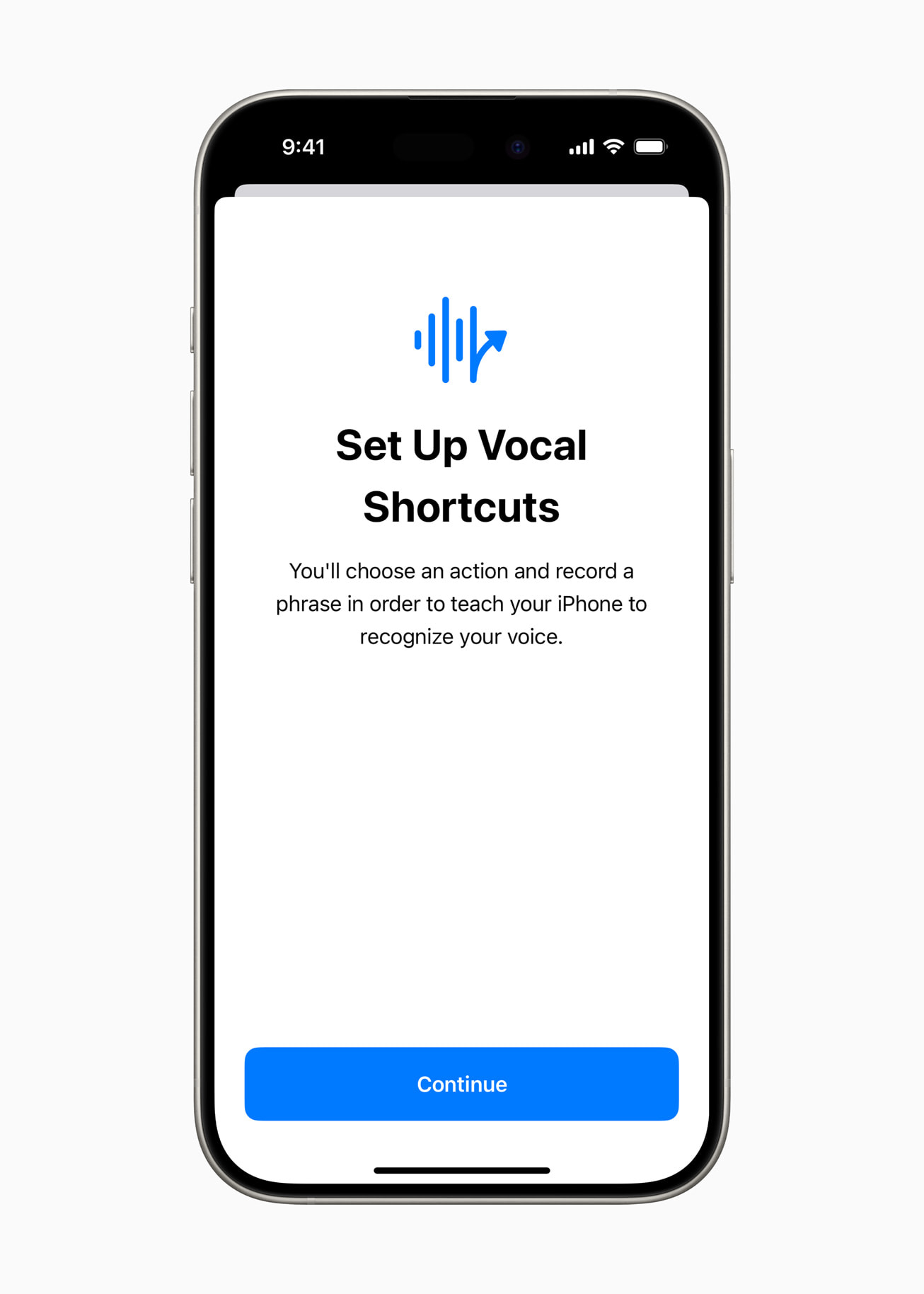

Scorciatoie vocali

Con le Scorciatoie vocali, gli utenti di iPhone e iPad possono assegnare frasi personalizzate che Siri può comprendere per avviare scorciatoie e completare compiti complessi. Ascolta discorsi atipici, un’altra nuova funzionalità, offre agli utenti un’opzione per migliorare il riconoscimento del linguaggio per una gamma più ampia di linguaggio. Ascolta discorsi atipici utilizza l’apprendimento automatico on-device per riconoscere i modelli di linguaggio dell’utente. Progettate per gli utenti con condizioni acquisite o progressive che influenzano il linguaggio, come la paralisi cerebrale, la sclerosi laterale amiotrofica (SLA) o ictus, queste funzionalità forniscono un nuovo livello di personalizzazione e controllo, basandosi su funzionalità introdotte in iOS 17 per gli utenti che non parlano o che rischiano di perdere la capacità di parlare.

“L’intelligenza artificiale ha il potenziale per migliorare il riconoscimento del linguaggio per milioni di persone con linguaggio atipico, quindi siamo entusiasti che Apple stia portando queste nuove funzionalità di accessibilità ai consumatori”, ha detto Mark Hasegawa-Johnson, direttore principale del Progetto di Accessibilità del Linguaggio presso l’Istituto Beckman per la Scienza e la Tecnologia Avanzate dell’Università dell’Illinois Urbana-Champaign. “Il Progetto di Accessibilità del Linguaggio è stato progettato come uno sforzo comunitario ampio e supportato per aiutare le aziende e le università a rendere il riconoscimento del linguaggio più robusto ed efficace e Apple è tra i sostenitori dell’accessibilità che hanno reso possibile il Progetto di Accessibilità del Linguaggio.”

Vehicle Motion Cues

Vehicle Motion Cues per iPhone e iPad che può aiutare a ridurre il mal d’auto per i passeggeri in veicoli in movimento. Le ricerche mostrano che il mal d’auto è comunemente causato da un conflitto sensoriale tra ciò che una persona vede e ciò che sente, il che può impedire a alcuni utenti di utilizzare comodamente iPhone o iPad mentre sono in un veicolo in movimento. Con le Indicazioni sul Vehicle Motion Cues, punti animati sui bordi dello schermo rappresentano i cambiamenti nel movimento del veicolo per aiutare a ridurre il conflitto sensoriale senza interferire con il contenuto principale. Utilizzando i sensori integrati in iPhone e iPad, la funzione riconosce quando un utente si trova in un veicolo in movimento e rispondono di conseguenza. La funzione può essere impostata per essere visualizzata automaticamente su iPhone o può essere attivata e disattivata dal Centro di Controllo.

CarPlay

Le funzionalità di accessibilità in arrivo su CarPlay includono il Controllo Vocale, i Filtri di Colore e il Riconoscimento del Suono. Con il Controllo Vocale, gli utenti possono navigare su CarPlay e controllare le app solo con la voce. Con il Riconoscimento del Suono, i conducenti o i passeggeri sordi o ipoudenti possono attivare gli avvisi per essere notificati di clacson e sirene delle auto. Per gli utenti daltonici, i Filtri di Colore rendono l’interfaccia di CarPlay visivamente più facile da usare, con ulteriori funzionalità di accessibilità visiva tra cui Testo in Grassetto e Testo Grande.

Funzionalità di accessibilità in arrivo su visionOS

Quest’anno, le funzionalità di accessibilità in arrivo su visionOS includeranno Sottotitoli Live a livello di sistema per aiutare tutti, inclusi gli utenti sordi o ipoudenti, a seguire il dialogo parlato nelle conversazioni dal vivo e nell’audio delle app. Con i Sottotitoli Live per FaceTime su visionOS, più utenti possono facilmente godersi l’esperienza unica di connettersi e collaborare usando il loro Persona. Apple Vision Pro aggiungerà la capacità di spostare i sottotitoli utilizzando la barra della finestra durante i Video Immersivi Apple, oltre al supporto per ulteriori dispositivi acustici Made for iPhone e processori acustici cocleari. Gli aggiornamenti per l’accessibilità della visione includeranno l’aggiunta di Riduci la Trasparenza, Inverti Intelligentemente e Abbassa le Luci Lampeggianti per gli utenti con bassa visione o coloro che desiderano evitare luci intense e lampeggianti.

Queste funzionalità si uniscono alle decine di funzionalità di accessibilità già disponibili in Apple Vision Pro, che offre un sistema di input flessibile e un’interfaccia intuitiva progettata per una vasta gamma di utenti. Funzionalità come VoiceOver, Zoom e Filtri di Colore possono anche fornire agli utenti non vedenti o con bassa visione l’accesso alla computazione spaziale, mentre funzionalità come Guided Access possono supportare gli utenti con disabilità cognitive. Gli utenti possono controllare Vision Pro con qualsiasi combinazione di occhi, mani o voce, con funzionalità di accessibilità tra cui Controllo Interruttore, Azioni Sonore e Controllo dello Sguardo che possono anche aiutare coloro con disabilità fisiche.

“Apple Vision Pro è senza dubbio la tecnologia più accessibile che abbia mai usato”, ha detto Ryan Hudson-Peralta, un designer di prodotti con sede a Detroit, consulente di accessibilità e cofondatore di Equal Accessibility LLC. “Essendo nato senza mani e impossibilitato a camminare, so che il mondo non è stato progettato con me in mente, quindi è stato incredibile vedere che visionOS funziona semplicemente. È una testimonianza del potere e dell’importanza del design accessibile e inclusivo.”

Aggiornamenti Aggiuntivi

- Per gli utenti non vedenti o ipovedenti, VoiceOver includerà nuove voci,, controllo del volume personalizzabile e la possibilità di personalizzare le scorciatoie da tastiera di VoiceOver su Mac.

- Lente di ingrandimento offrirà una nuova Modalità Lettura e l’opzione di avviare facilmente la Modalità Rilevamento con il pulsante Azione.

- Gli utenti in Braille avranno un nuovo modo per avviare e rimanere in Braille Screen Input per un controllo e una modifica del testo più rapidi; disponibilità in lingua giapponese per Braille Screen Input; supporto per braille multiriga con Dot Pad; e l’opzione di scegliere diverse tabelle di input e output.

- Per gli utenti ipovedenti, la digitazione al passaggio del mouse mostra testi più grandi durante la digitazione in un campo di testo e nel carattere e colore preferiti dall’utente.

- Per gli utenti a rischio di perdere la capacità di parlare, Voce Personale sarà disponibile in cinese mandarino. Gli utenti che hanno difficoltà a pronunciare o leggere frasi intere potranno creare una Voce Personale utilizzando frasi abbreviate.

- Per gli utenti non parlati, Live Speech includerà categorie e compatibilità simultanea con Sottotitoli Live.

- Per gli utenti con disabilità fisiche, il Trackpad Virtuale per AssistiveTouch consente agli utenti di controllare il proprio dispositivo utilizzando una piccola regione dello schermo come trackpad ridimensionabile.

- la digitazione al passaggio del mouse includerà l’opzione di utilizzare le fotocamere in iPhone e iPad per riconoscere i gesti di tocco con il dito come interruttori.

Voice Control offrirà supporto per vocabolari personalizzati e parole complesse.

Leggi o Aggiungi Commenti