Il settore della ricerca sull’intelligenza artificiale di Apple rivela un modello che renderà più rapido ed efficiente impartire comandi a Siri, convertendo qualsiasi contesto in testo, più facile da analizzare da un Large Language Model (LLM).

La ricerca sull’intelligenza artificiale di Apple continua a essere pubblicata mentre l’azienda si avvicina al lancio pubblico delle sue iniziative di intelligenza artificiale a giugno durante la WWDC. Finora sono stati pubblicati vari studi, tra cui uno strumento di animazione di immagini.

L’ultimo articolo è stato condiviso per la prima volta da VentureBeat. Il documento dettaglia qualcosa chiamato ReALM – Reference Resolution As Language Modeling.

Far sì che un programma informatico esegua un’azione basata su input di linguaggio vago, come il modo in cui un utente potrebbe dire “questo” o “quello”, è chiamato risoluzione di riferimento. È un problema complesso da risolvere poiché i computer non possono interpretare le immagini come fanno gli esseri umani, ma Apple potrebbe aver trovato una soluzione semplificata utilizzando LLM.

Parlando con assistenti intelligenti come Siri, gli utenti potrebbero fare riferimento a una serie di informazioni contestuali con cui interagire, come compiti in background, dati visualizzati e altre entità non conversazionali. I metodi di analisi tradizionali si basano su modelli incredibilmente grandi e materiali di riferimento come le immagini, ma Apple ha semplificato l’approccio convertendo tutto in testo.

La società ha scoperto che i suoi modelli ReALM più piccoli hanno prestazioni simili a GPT-4 con molto meno parametri, quindi più adatti per l’uso on-device. Aumentare i parametri utilizzati in ReALM lo ha reso notevolmente più performante rispetto a GPT-4.

Uno dei motivi di questo aumento delle prestazioni è la dipendenza di GPT-4 dall’analisi delle immagini per comprendere le informazioni visualizzate. Gran parte dei dati di addestramento delle immagini si basa su immagini naturali, non su pagine web basate su codice artificiale riempite di testo, quindi il riconoscimento ottico dei caratteri diretto è meno efficiente.

Convertire un’immagine in testo consente a ReALM di evitare la necessità di questi avanzati parametri di riconoscimento delle immagini, rendendolo quindi più piccolo e più efficiente. Apple evita anche problemi con le allucinazioni includendo la capacità di limitare la decodifica o utilizzare una semplice post-elaborazione.

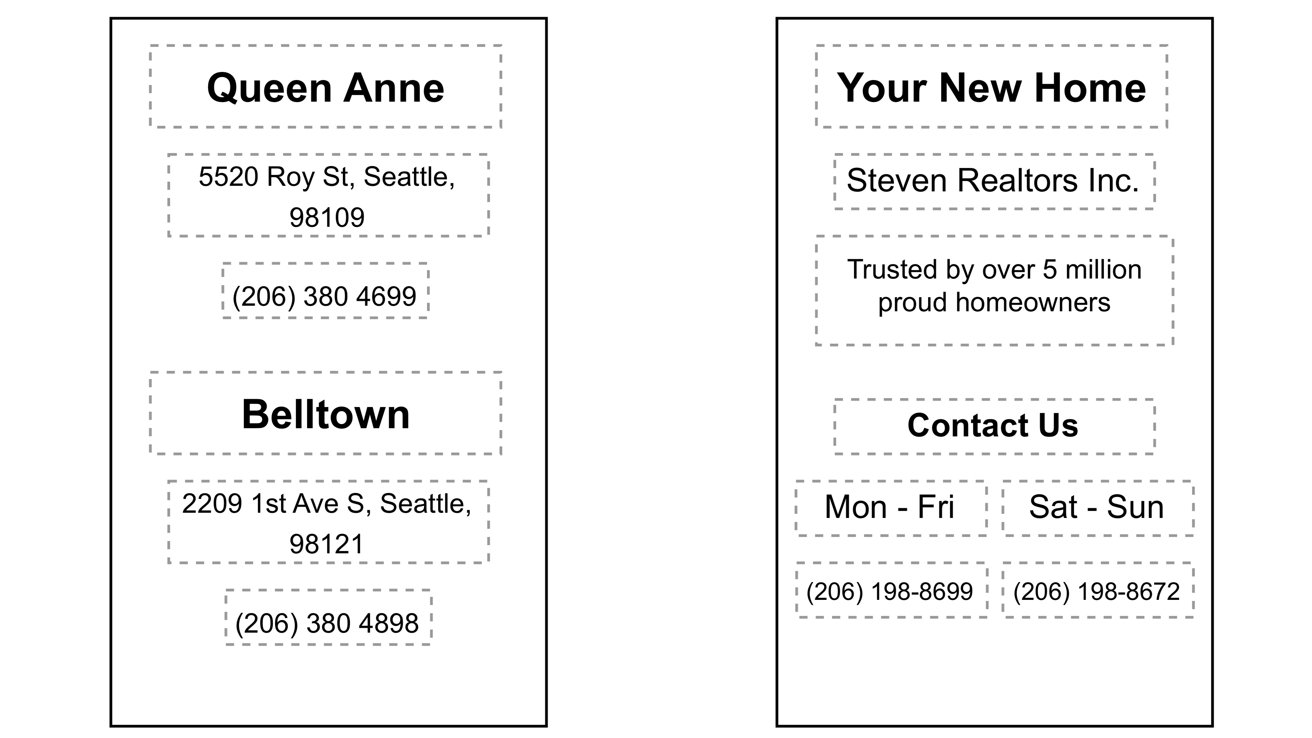

Ad esempio, se stiamo scorrendo un sito web e decidiamo che vogliamo chiamare l’azienda, dire semplicemente “chiama l’azienda” richiede a Siri di interpretare cosa intendiamo dato il contesto. Sarebbe in grado di “vedere” che c’è un numero di telefono sulla pagina etichettato come il numero dell’azienda e chiamarlo senza ulteriori prompt dell’utente.

Apple sta lavorando per rilasciare una strategia completa di intelligenza artificiale durante la WWDC 2024. Alcuni rumors suggeriscono che l’azienda si affiderà a modelli più piccoli on-device che preservano la privacy e la sicurezza, mentre concederà in licenza gli LLM di altre aziende per l’elaborazione off-device più controversa piena di questioni etiche.

Leggi o Aggiungi Commenti