Apple ha aggiunto un’altra freccia al suo arco crescente nell’ambito dell’intelligenza artificiale (IA) con la creazione di uno strumento che sfrutta modelli linguistici di grandi dimensioni (LLM) per animare immagini statiche basate su suggerimenti di testo dell’utente.

La novità è descritta in un nuovo articolo di ricerca di Apple dal titolo “Keyframer: Empowering Animation Design Using Large Language Models”.

“Mentre le interfacce di prompting one-shot sono comuni nei sistemi commerciali di testo-immagine come Dall·E e Midjourney, sosteniamo che le animazioni richiedano un set di considerazioni utente più complesse, come il timing e la coordinazione, difficili da specificare completamente in un unico prompt; pertanto, potrebbero essere necessari approcci alternativi che consentano agli utenti di costruire e perfezionare iterativamente i design generati, specialmente per le animazioni”.

“Abbiamo combinato i principi emergenti di design per il prompting basato su linguaggio degli artefatti di design con le capacità di generazione di codice di LLM per costruire uno strumento di animazione alimentato da intelligenza artificiale chiamato Keyframer. Con Keyframer, gli utenti possono creare illustrazioni animate da immagini 2D statiche attraverso il prompting di linguaggio naturale. Utilizzando GPT-4, Keyframer genera il codice di animazione CSS per animare un input Scalable Vector Graphic (SVG).”

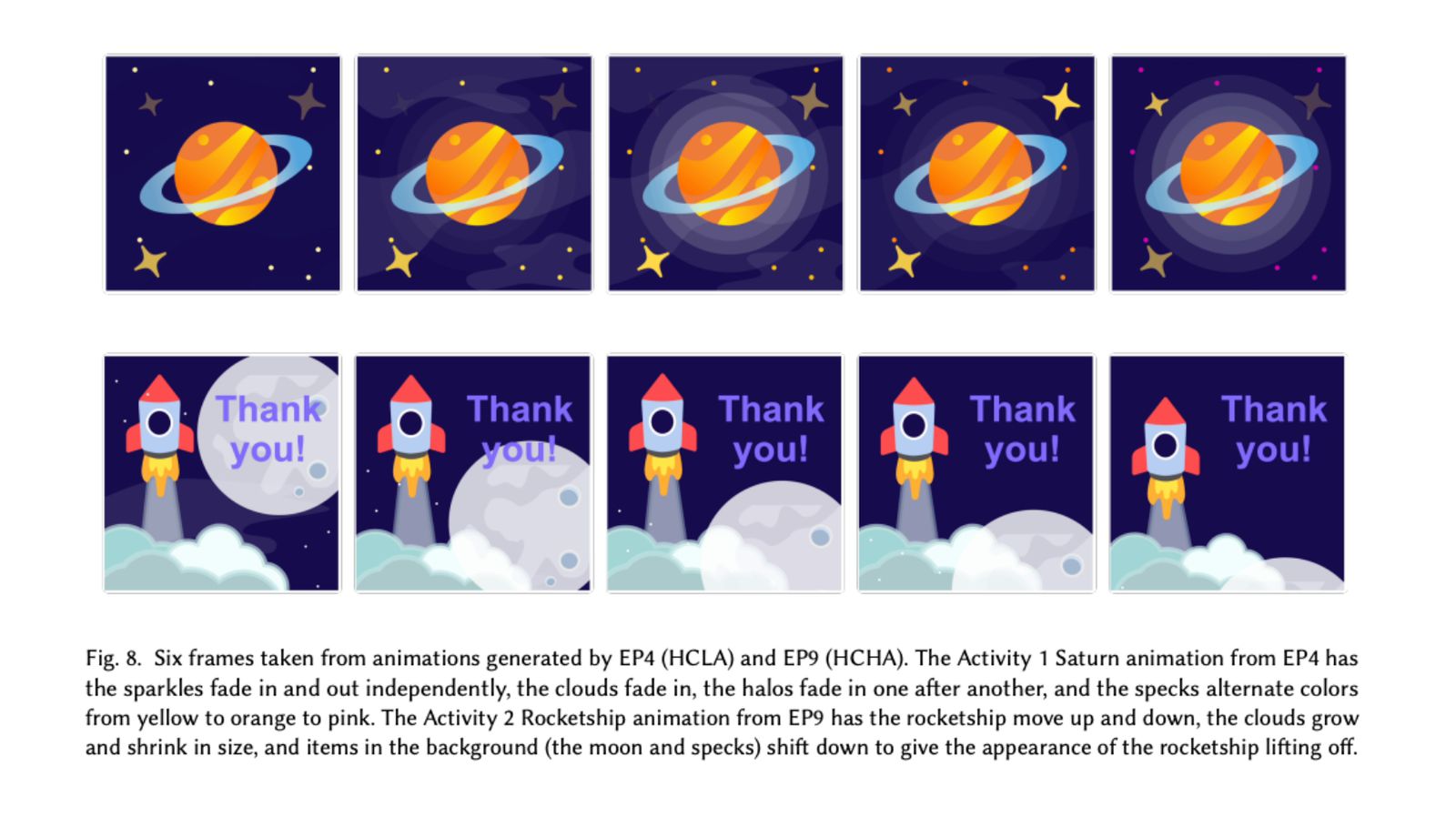

Per creare un’animazione, l’utente carica un’immagine SVG, ad esempio di un razzo spaziale, e inserisce un prompt come “genera tre design in cui il cielo sfuma in colori diversi e le stelle scintillano”. Keyframer genera quindi il codice CSS per l’animazione, e l’utente può perfezionarlo modificando direttamente il codice o inserendo prompt di testo aggiuntivi.

“Keyframer ha consentito agli utenti di perfezionare iterativamente i loro design attraverso un prompting sequenziale, anziché dover considerare l’intero design inizialmente”, spiegano gli autori. “Con questo lavoro, speriamo di ispirare futuri strumenti di design per animazioni che combinino le potenti capacità generative di LLM per accelerare la prototipazione del design con editor dinamici che consentano ai creatori di mantenere il controllo creativo.”

Secondo l’articolo, la ricerca è basata su interviste con progettisti di animazioni professionisti e ingegneri.

“Penso che sia stato molto più veloce rispetto a molte cose che ho fatto”, ha detto uno dei partecipanti allo studio citato nell’articolo. “Penso che fare qualcosa del genere prima avrebbe richiesto solo ore.”

L’innovazione è solo l’ultima di una serie di avanzamenti nell’IA da parte di Apple. La scorsa settimana, i ricercatori della società hanno rilasciato un modello IA che sfrutta il potere di LLM multimodali per eseguire modifiche a livello di pixel sulle immagini.

A fine dicembre, il colosso di Cupertino ha anche rivelato di aver compiuto progressi nel deployare LLM su iPhone e altri dispositivi Apple con memoria limitata attraverso l’invenzione di una tecnica innovativa di utilizzo della memoria flash.

Sia The Information che l’analista Jeff Pu hanno dichiarato che Apple avrà una sorta di funzione generativa di IA disponibile su iPhone e iPad più avanti nell’anno, con il rilascio di iOS 18. La prossima versione del software mobile di Apple dovrebbe includere una versione migliorata di Siri con funzionalità di IA generativa simili a ChatGPT, e ha il potenziale per essere “l’aggiornamento più grande” nella storia dell’iPhone, secondo il giornalista di Bloomberg Mark Gurman.

Leggi o Aggiungi Commenti