Oltre a rendere disponibile la crittografia end-to-end per le Foto di iCloud, Apple ha annunciato di aver abbandonato i suoi piani per rilevare il materiale pedopornografico (CSAM) archiviato nello Foto di iCloud.

Ecco la dichiarazione della società:

“Dopo un’ampia consultazione con esperti per raccogliere feedback sulle iniziative di protezione dei minori che abbiamo proposto l’anno scorso, stiamo approfondendo il nostro investimento nella funzione Communication Safety che abbiamo reso disponibile per la prima volta nel dicembre 2021.

Abbiamo inoltre deciso di non andare avanti con il nostro rilevamento di materiale pedopornografico proposto in precedenza per le Foto di iCloud. I bambini possono essere protetti senza che le aziende raccolgano i dati personali e continueremo a lavorare con i governi, i sostenitori dei bambini e altre aziende per aiutare a proteggere i giovani, preservare il loro diritto alla privacy e rendere Internet un luogo più sicuro per i bambini e per tutti noi”.

Nell’agosto 2021, Apple ha annunciato i piani per tre nuove funzionalità per la sicurezza dei bambini, tra cui un sistema per rilevare le immagini CSAM note archiviate nelle Foto di iCloud, Communication Safety che offusca le foto sessualmente esplicite nell’app Messaggi e Siri e Search per fornire ai genitori e bambini informazioni più dettagliate sull’argomento e per aiutarli nel caso dovesse presentarsi un caso di abuso.

Communication Safety è stato lanciato negli Stati Uniti con iOS 15.2 nel dicembre 2021 e da allora la società ha esteso la funzione in Regno Unito, Canada, Australia e Nuova Zelanda, così come Siri e Search. Tuttavia, il rilevamento CSAM non è mai stato lanciato.

Inizialmente Apple aveva affermato che il rilevamento CSAM sarebbe stato implementato in un aggiornamento di iOS 15 e iPadOS 15 entro la fine del 2021, ma alla fine la società ha rinviato la funzionalità sulla base di “feedback di clienti, gruppi di difesa, ricercatori e altri”. Ora, dopo un anno di silenzio, Apple ha abbandonato del tutto i piani di rilevamento CSAM.

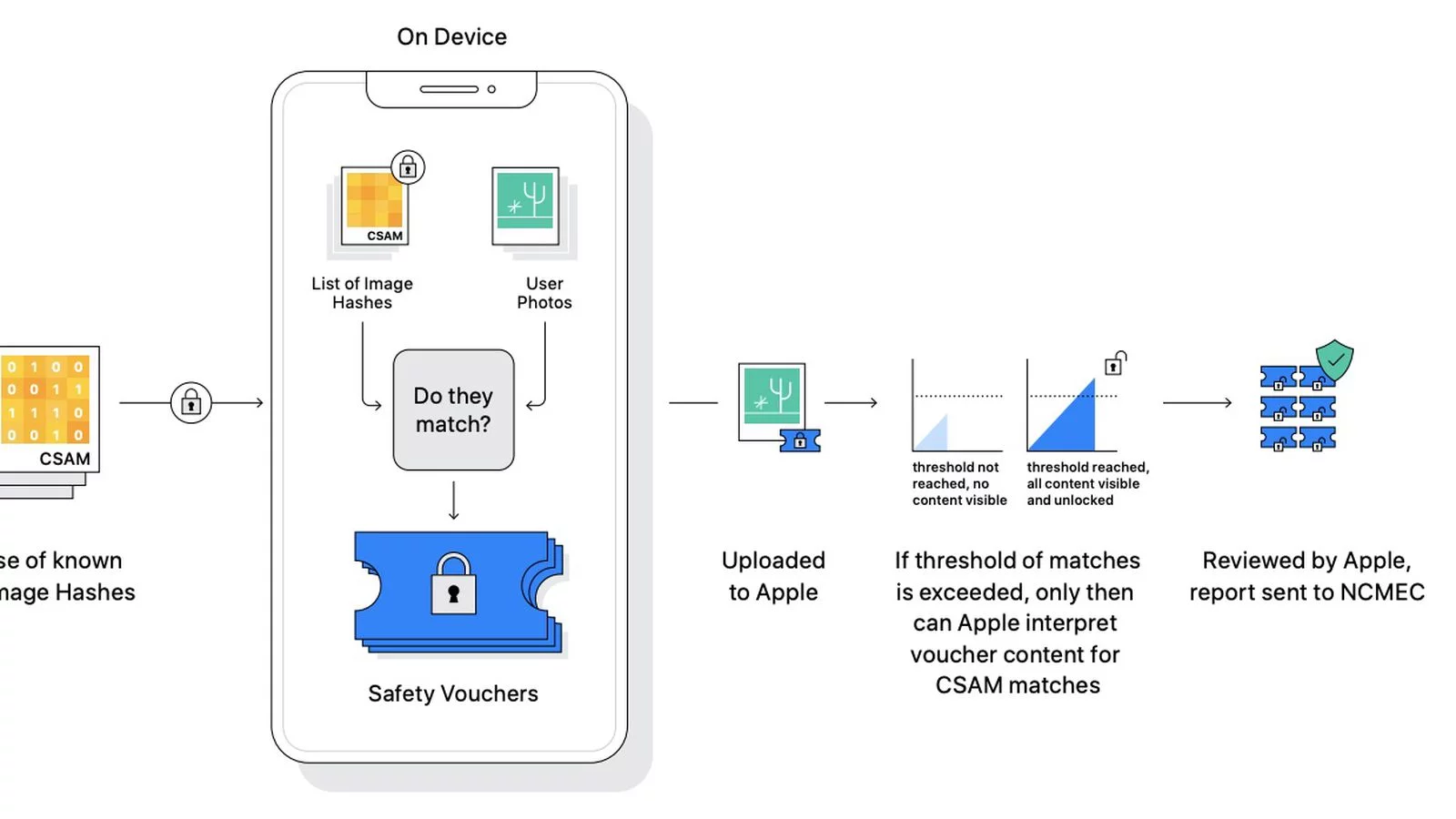

La società ha affermato che il suo sistema di rilevamento CSAM è stato “progettato pensando alla privacy degli utenti”. Il sistema avrebbe eseguito “la corrispondenza sul dispositivo utilizzando un database di immagini CSAM noti ad organizzazioni per la sicurezza dei bambini, che Apple avrebbe trasformato in un “insieme illeggibile di hash archiviato in modo sicuro sui dispositivi degli utenti”.

Apple ha pianificato di segnalare gli account iCloud con hash di immagine CSAM noti al National Center for Missing and Exploited Children (NCMEC), un’organizzazione senza scopo di lucro che lavora in collaborazione con le forze dell’ordine statunitensi. La società ha affermato che ci sarebbe stata una “soglia” che avrebbe garantito “meno di una possibilità su un trilione all’anno” che un account venisse contrassegnato in modo errato dal sistema, oltre a una revisione manuale degli account contrassegnati da parte di un essere umano.

I piani di Apple sono stati criticati da una vasta gamma di individui e organizzazioni, inclusi ricercatori di sicurezza, Electronic Frontier Foundation (EFF), politici, ricercatori universitari e persino da alcuni dipendenti della società.

Alcuni critici hanno sostenuto che la funzione avrebbe creato una “backdoor” nei dispositivi, che i governi e/o le forze dell’ordine avrebbero potuto utilizzare per sorvegliare gli utenti. Un’altra preoccupazione riguardava i falsi positivi, inclusa la possibilità che qualcuno aggiungesse intenzionalmente immagini CSAM all’account iCloud di un’altra persona.

Leggi o Aggiungi Commenti