Una coalizione internazionale composta da oltre 90 gruppi per i diritti civili e politici ha chiesto ad Apple di abbandonare i suoi piani per “introdurre funzionalità di sorveglianza in iPhone, iPad e altri prodotti”.

Com ben sappiamo, le future versioni di iOS e iPadOS utilizzeranno nuovi strumenti di crittografia per limitare la condivisione di materiale pedopornografico (Child Sexual Abuse Material, CSAM).

“Sebbene queste capacità abbiano lo scopo di proteggere i bambini e ridurre la diffusione di materiale pedopornografico (CSAM), siamo preoccupati che vengano utilizzate per censurare comunicazioni, minacciare la privacy e la sicurezza delle persone in tutto il mondo e avere disastrosi conseguenze per molti bambini”, hanno scritto i gruppi nella lettera.

Alcuni firmatari della lettera temono che il sistema di scansione CSAM di Apple possa essere utilizzato in nazioni con sistemi legali diversi per cercare contenuti politici o altri contenuti sensibili.

“Una volta integrata questa funzione di backdoor, i governi potrebbero costringere Apple a estendere la notifica ad altri account e a rilevare immagini discutibili per ragioni diverse dall’essere sessualmente esplicite”, si legge nella lettera.

La lettera invita anche Apple ad abbandonare le modifiche pianificate a iMessage negli account familiari, che cercherebbero di identificare e offuscare la nudità nei messaggi dei bambini, consentendo loro di visualizzarla solo se i genitori vengono avvisati. I firmatari affermano che non solo il passaggio potrebbe mettere in pericolo i bambini o coloro che cercano materiale educativo, ma potrebbe anche violare la crittografia end-to-end di iMessage.

Il piano di Apple per rilevare le immagini CSAM archiviate in iCloud Photos è stato particolarmente controverso e ha suscitato preoccupazioni da parte di ricercatori sulla sicurezza, accademici, gruppi per la privacy e altri sul sistema che potrebbe potenzialmente essere utilizzato dai governi come forma di sorveglianza di massa. La società ha cercato di affrontare le preoccupazioni pubblicando documenti aggiuntivi e una pagina di domande frequenti che spiega come funzionerà il sistema di rilevamento delle immagini e sostenendo che il rischio di falsi rilevamenti è basso.

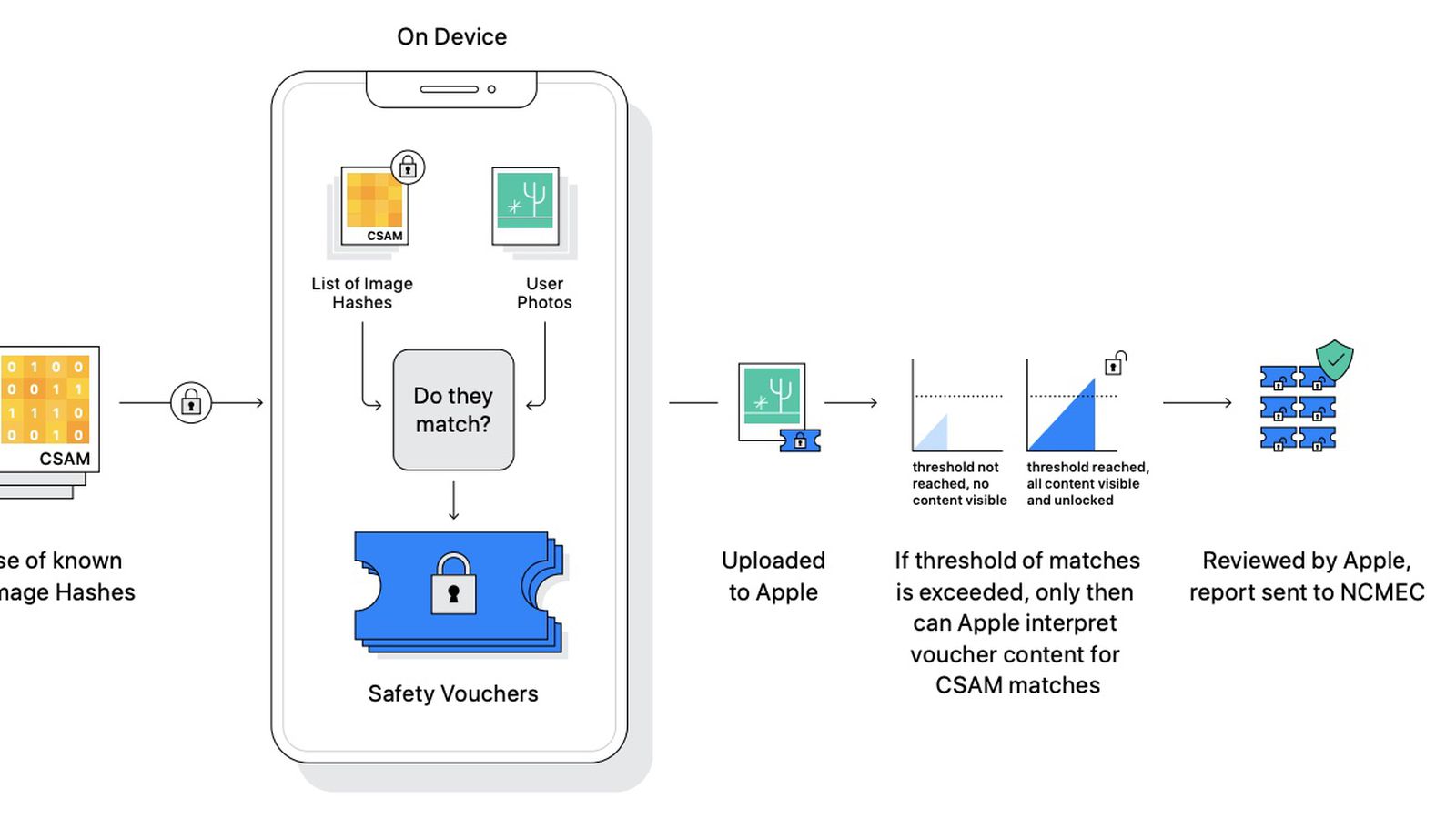

Il colosso di Cupertino ha affermato che il sistema non analizzerà tutte le foto presenti nella libreria iCloud, ma solo quelle con hash che combaciano con le immagini del database CSAM.

Come funziona il sistema per limitare la diffusione di materiale pedopornografico

Tutti i sistemi CSAM funzionano importando un database di materiale pedopornografico noto da organizzazioni come il National Center for Missing and Exploited Children. Questo database viene fornito sotto forma di hash, o fingerprint, derivate dalle immagini.

Mentre la maggior parte dei giganti della tecnologia esegue la scansione delle foto caricate nel cloud, Apple utilizza un algoritmo NeuralHash sull’iPhone di un cliente per generare hash delle foto archiviate e quindi confrontarle con una copia scaricata degli hash CSAM.

Leggi o Aggiungi Commenti