Apple, tramite un comunicato stampa, ha annunciato l’arrivo nei suoi sistemi operativi in uscita in autunno di nuove funzionalità volte a tutelare la sicurezza dei bambini e a limitare la diffusione di materiale pedopornografico attraverso le diverse piattaforme di comunicazione.

In quest’ottica, il gigante di Cupertino andrà a migliorare tre aree, avvalendosi della collaborazione di esperti del settore.

- L’app di sistema Messaggi sfrutterà il machine learning on-device per scovare e segnalare materiale sensibile, senza tuttavia violare la privacy delle comunicazioni. Apple non avrà accesso ai messaggi.

- Le prossime versioni di iOS e iPadOS utilizzeranno nuovi strumenti di crittografia per limitare la condivisione di materiale pedopornografico (Child Sexual Abuse Material, CSAM).

- Siri e Search forniranno a genitori e bambini informazioni più dettagliate sull’argomento e li aiuteranno nel caso dovesse presentarsi un caso di abuso.

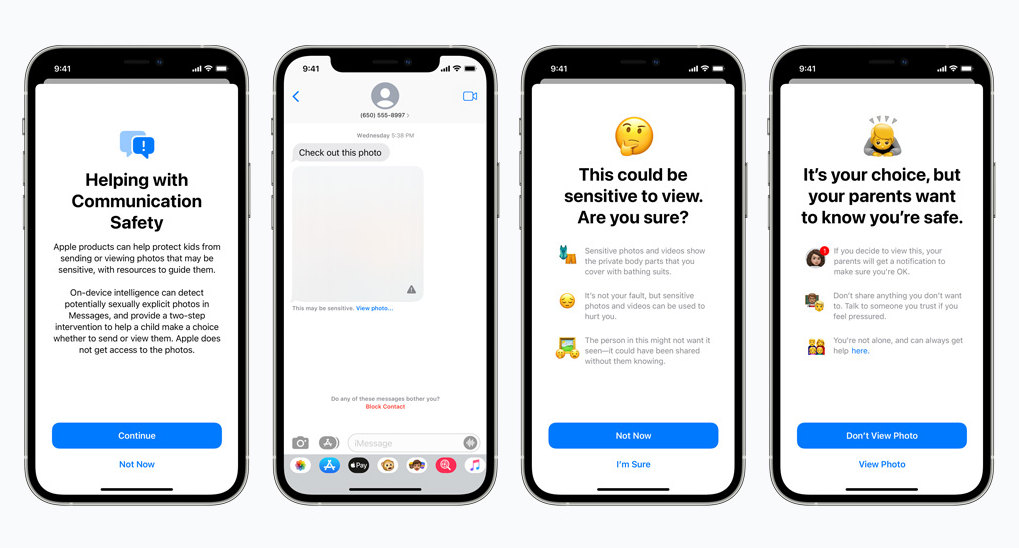

Communication Safety

La funzione Communication Safety dell’app Messaggi su iPhone, iPad e Mac avviserà l’utente in caso di fotografie sessualmente esplicite, ricevute o inviate che siano. Il machine learning analizzerà i contenuti multimediali e oscurerà automaticamente tutti quelli che contengono materiale esplicito.

Quando l’utente proverà a visualizzare una foto segnalata dal machine learning nell’app Messaggi, verrà informato genericamente del suo contenuto, ovvero che potrebbe contenere nudità e che potrebbe urtare la sensibilità. Nel caso in cui l’utente proprietario del dispositivo Apple dovesse essere un bambino, sarà possibile attivare un’opzione che invierà ai genitori una notifica in caso di materiale sensibile ricevuto o inviato.

Analisi delle foto in iCloud

A partire da iOS 15 e iPadOS 15, Apple sarà in grado di rilevare materiale pedopornografico (CSAM) all’interno della galleria fotografica memorizzata su iCloud. In tal modo, l’azienda californiana potrà inoltrare le segnalazioni al National Center for Missing and Exploited Children (NCMEC), organizzazione non-profit che collabora con le forze dell’ordine statunitensi.

In sintesi, spiega Apple, il nuovo sistema utilizzerà il machine learning on-device per confrontare le foto del rullino con un database di immagini CSAM fornite dal NCMEC e altre organizzazioni impegnate contro gli abusi sui minori.

Tale tecnologia di hashing, chiamata NeuralHash, analizzerà una foto e la convertirà in un numero specifico associato unicamente a quella stessa foto. Apple fa sapere che questo sistema è molto preciso, con un margine di errore bassissimo, e che tutela la privacy di tutti i suoi utenti andando a segnalare unicamente coloro che sono in possesso del materiale incriminato.

Siri e Search

Infine, Siri e Spotlight Search su tutti i dispositivi forniranno risorse aggiuntive per aiutare genitori e figli a vivere un’esperienza online sicura e, nel caso, a gestire una situazione rischiosa. Ad esempio, si potrà chiedere a Siri un aiuto per effettuare una segnalazione.

Tutte le novità sopra descritte saranno disponibili a partire da iOS 15, iPadOS 15, watchOS 8 e macOS Monterey e saranno inizialmente accessibili solo negli Stati Uniti.

Leggi o Aggiungi Commenti