Apple sta sviluppando un modo per aiutare a interpretare le richieste di un utente aggiungendo l’analisi facciale a una versione futura di Siri o di un altro sistema. L’obiettivo è ridurre il numero di volte in cui una richiesta vocale viene interpretata in modo errato e farlo tentando di analizzare le emozioni.

“Gli assistenti vocali possono eseguire azioni per conto di un utente”, afferma Apple nel brevetto statunitense numero 20190348037. “Le azioni possono essere eseguite in risposta a un input dell’utente in linguaggio naturale, come una frase pronunciata dall’utente. In alcune circostanze, un’azione intrapresa da un agente software intelligente potrebbe non corrispondere all’azione prevista dall’utente. ”

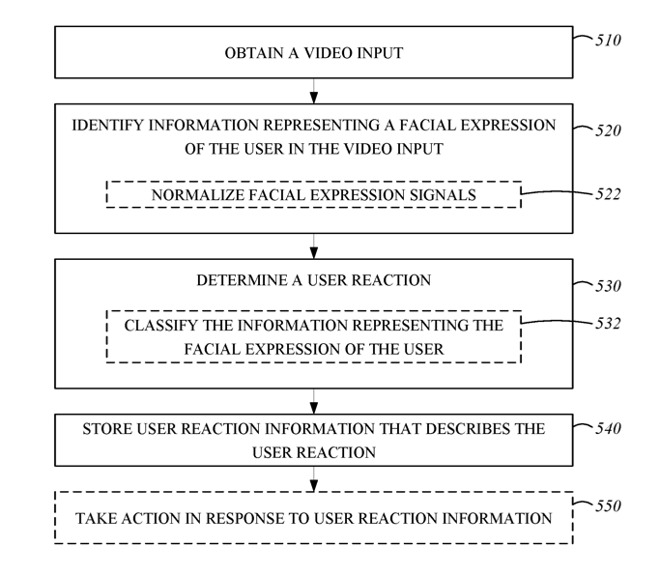

“Ad esempio”, continua, “l’immagine del volto nell’ingresso video può essere analizzata per determinare se determinati muscoli o gruppi muscolari vengono attivati identificando forme o movimenti”.

Parte del sistema prevede l’utilizzo del riconoscimento facciale per identificare l’utente e quindi fornire azioni personalizzate come il recupero dell’email di quella persona o la riproduzione di playlist musicali personali.

È anche inteso, tuttavia, leggere lo stato emotivo di un utente.

“[Le] informazioni sulla reazione dell’utente sono espresse come una o più metriche come una probabilità che la reazione dell’utente corrisponda a un certo stato come positivo o negativo,” continua il brevetto “o un grado in cui l’utente sta esprimendo la reazione “.

Questo potrebbe aiutare in una situazione in cui il comando parlato può essere interpretato in diversi modi. In tal caso, Siri potrebbe calcolare il significato più probabile e agire su di esso, quindi utilizzare il riconoscimento facciale per vedere se l’utente è soddisfatto o meno.

Il sistema funziona “ottenendo, tramite un microfono, un ingresso audio e ottenendo, tramite una telecamera, una o più immagini“. Apple osserva che le espressioni possono avere significati diversi, ma il suo metodo classifica la gamma di significati possibili secondo il Facial Action Coding System (FACS).

Questo è uno standard per la tassonomia facciale, creato per la prima volta negli anni ’70, che classifica ogni possibile espressione facciale in un ampio catalogo di riferimento.

Utilizzando FACS, il sistema di Apple assegna i punteggi per determinare la probabilità di interpretazione corretta e quindi far reagire o rispondere di conseguenza a Siri.

Leggi o Aggiungi Commenti