Con il Machine Learning, le app possono diventare davvero più evolute che mai. Possono riconoscere cose ed effettuare azioni automaticamente secondo delle regole o le abitudini dell’utente. Apple sta offrendo una piccola app demo, a scopo illustrativo, alla WWDC ed in questo articolo vi mostriamo un video.

Una delle funzioni più interessanti di iOS 11 è l’implementazione del Core ML, un nuovo framework che permette agli sviluppatori di integrare le capacità del Machine Learning all’interno delle proprie applicazioni.

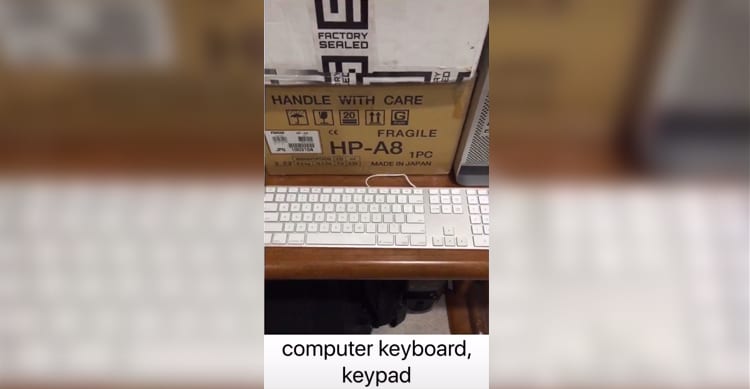

Una delle varie funzionalità del Core ML è quella di riconoscere ed identificare gli oggetti del mondo reale, in tempo reale.

Durante la WWDC Apple sta fornendo un’applicazione Demo per dimostrare come è rapido il riconoscimento e come avviene semplicemente inquadrando gli oggetti con la fotocamera.

Al momento l’app è stata configurata per riconoscere circa 1000 oggetti. Nel video qui sotto la vediamo in funzione su diversi oggetti inclusi nel catalogo. La prova fallisce sul primo modello di Mac Pro che non viene riconosciuto proprio per la fase preliminare di sviluppo e per le limitazioni di quest’applicazione demo.

Anche Google con la prossima versione del sistema operativo Android andrà ad implementare il Machine Learning nelle app native. Apple invece fornirà il suo framework agli sviluppatori per fare in modo che anche loro possano creare applicazioni più evolute che rappresenteranno la prossima era di App.

Nel giro di un paio d’anni il panorama delle applicazioni cambierà molto ed Apple tra CoreML ed ARKit ha già gettato le basi per confermarsi leader del settore.

I wasn’t joking either just got to get it at the right angle. This also really heats up this phone. pic.twitter.com/dvOEXdHHTn

— Paul Haddad (@tapbot_paul) 8 giugno 2017

Leggi o Aggiungi Commenti